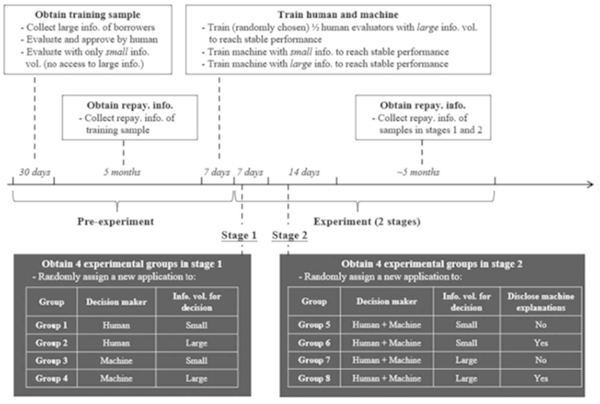

图 两阶段人机协同实验设计

在国家自然科学基金项目(批准号:72272003)等资助下,北京大学张颖婕副教授与海外合作者在人机协同管理研究领域取得新进展。研究成果以“1+1>2?信息、人类与机器(1+1>2? Information, Humans, and Machines)”为题,于2024年5月在《信息系统研究》(Information Systems Research)在线发表。论文链接:https://doi.org/10.1287/isre.2023.0305。

随着数据的爆炸式增长以及人工智能和自动化工作流程的快速兴起,人类与AI算法等先进技术的合作日益紧密。然而,这种人机互动也带来了诸多问题,尤其是在管理不断扩大的信息规模时所面临的挑战。鉴于AI算法在信息处理方面相较于人类决策者的优势,探讨人机协作的价值及其背后的原因显得尤为重要。尽管近年来的研究尝试揭示机器学习算法的“黑箱”,以减少人类的抵触情绪并提高效率,但该领域的研究结果仍不明确。本研究旨在通过考察信息复杂性和算法解释的共同影响,系统地回答这一问题。

本研究与一家线上借贷平台公司合作,设计并实施了两阶段实地实验以进行实证分析(如图)。研究根据信息复杂程度、人机协作参与度和算法解释的可用性,设置了不同的实验处理条件。研究结果表明,在信息量较大的情况下仅依靠算法解释,人类决策者无法为最终的协作结果带来额外价值;但当大量信息与算法解释相结合时,相较于仅由算法作出的决策,人类决策者的参与显著提升了决策效果,并降低了违约率。本研究进一步解构了其背后的机制,揭示了大量信息与算法解释的共存能够激发人类的主动反思,从而缩小性别差距并提高预测准确性。特别是,人类决策者能够自发地将新出现的特征与那些被忽视但可能纠正算法错误的特征联系起来。这种能力不仅凸显了人机协作的重要性,也为相关系统设计提供了新的见解。

从更广泛的研究意义来看,本研究揭示了在处理难度较低的任务时,算法通常持续优于人类。虽然大量信息的可获得性可能会引发人类代理对任务的关注,但这并不确保他们能够有效帮助算法。额外的提示对于引导人类代理积极反思复杂信息、应对不确定性至关重要,从而带来更优的决策结果。在信息成本、AI训练成本和员工智力成本日益增长的背景下,本研究不仅限于对人机协作效果的表面量化分析,还探讨了实现人机协作价值的条件和机制,使得研究结论更加稳健,并具备广泛的实践应用潜力。